Am Montag, den 7. Dezember 2015 gab es das von der Landeszentrale für politische Bildung Nordrhein-Westfalen im Landtag NRW veranstaltete „NRW-Forum: Zukunft Demokratie“ mit dem Thema Politik & Big Data (Hashtag #ZuDe15). Da ich Vormittags auch in Sachen Digitale Hochschule unterwegs war, konnte ich leider nur die Abschlussdiskussion live verfolgen. Dort fiel das Wort „Algorithmustransparenz“. Auf dem Podium saßen Birgit Kimmel (Eu-Initiative klicksafe.de / LMK), Marc Jan Eumann (Staatssekretär für Europa und Medien NRW) und Thomas Krüger (Präsident der Bundeszentrale für politische Bildung), die Moderation hatte Jan Hendrik Becker.

Außerdem wurde auch die „amerikanische Auffassung“ zur Privatsphäre a la Mark Zuckerberg (Facebook) und Eric Schmidt (Google) und der Gegensatz zu unserer andiskutiert, jeder habe im Prinzip das Recht von Jedem alles zu wissen.

Nun denn, wen dem so ist, dann möchte ich von Eric Schmidt den Google-Algorithmus wissen – und vielleicht noch so einiges andere mehr.

Das würde mich natürlich erheblich nach vorn bringen, um die Arbeitsweise der Suchmaschine nachzuvollziehen.

Allerdings würde mir das im Endeffekt nichts nützen. Ich glaube, Birgit Kimmel war`s, die „Algorithmustransparenz“ einforderte. Da fiel mir ein, dass die alleinige Kenntnis des Algorithmus gar nichts bringt, um sein Verhalten in bestimmten Situationen vorherzusagen.

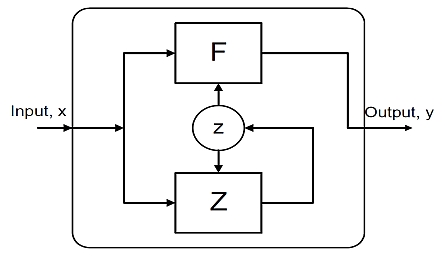

Ein Computer ist eine nicht-triviale Maschine. Das bedeutet, dass ihr Verhalten, also ihr Output, immer und grundsätzlich von mindestens zwei Dingen abhängt, vom aktuellen Input und vom inneren Zustand der Maschine. Um das Verhalten vorhersagen zu können, muss man neben dem Algorithmus auch die Geschichte der Inputs und der inneren Zustände kennen. Nicht-triviale Maschinen sind „geschichtsabhängig“. Sie sind daher analytisch unbestimmbar – nicht determinierbar – , aber sie sind synthetisch vorherbestimmbar, und zwar durch den Programmierer, der den Algorithmus entwirft. Aber selbst der Programmierer kann das Verhalten der Maschine nicht vorhersagen, wenn er die Geschichte der inneren Zustände nicht kennt.

Das fand der Mathematiker Arthur Gill bereits 1962 heraus und dokumentierte es in seinem Buch zur Einführung in die Theorie der Maschinen „mit endlichen Zuständen“.[1]

Näheres dazu mit einem konkreten Beispiel gibt es auch hier.[2]

Also Tschüss Algorithmustransparenz.

Braucht jemand einen Beweis? Hmm. Vielleicht reichen ja Indizien.

Ähm, da fällt mir ein, wie lange hat es eigentlich gedauert, bis das besondere Verhalten der VW-Dieselmotoren in den USA auffiel? Eben.

Übrigens, schimpft jemand noch über mangelnde Innovationskraft in Deutschland?

Also in Informatik und Software sind wir echt spitze. Zum Beispiel bei VW. Geile Bordcomputer.

Algorithmustransparenz? Industrie 4.0 transparent? Ja, nee, is klar.

Bestes, Nick H. aka Joachim Paul

[1] Gill, Arthur; Introduction to the Theory of Finite-State Machines, McGraw-Hill, New York 1962

[2] Goldammer, Eberhard von; Paul, Joachim; Autonomie in Biologie und Technik; in: Jahrbuch für Selbstorganisation ’96, Bd. 6, Realitäten und Rationalitäten, Hrsg.: Axel Ziemke, Rudolf Kaehr, Duncker und Humblot, 1996;

online: http://www.vordenker.de/autonomie/autonomie.pdf